Introducción

Contenidos

Machine learning y Deep learning son ramas de la Inteligencia Artificial que han atraído gran interés durante los últimos años. Las redes neuronales profundas se han constituido como una rama independiente del machine learning tradicional, debido a sus particularidades, que las hacen más complejas de implementar, pero que a su vez permiten obtener importantes ganancias en desempeño, y las posicionan como el algoritmo más relevante del futuro.

Machine learning e Inteligencia artificial

Tradicionalmente se define el concepto de Machine Learning como una rama de la inteligencia artificial cuyo objetivo es desarrollar modelos matemáticos que permiten que los computadores aprendan. Se trata de una ciencia cuyo objetivo es encontrar relaciones entre variables y generar predicciones a partir de una muestra de datos, que sean generalizables, es decir, que sean válidas para nuevos datos, que no se hayan utilizado para entrenar el modelo. Existe una gran cantidad modelos de machine learning. Entre los más populares se encuentra la regresión lineal, la regresión logística, Naive Bayes, árboles de decisión, KNN, SVM, modelos de ensemble learning (bagging y boosting), y las redes neuronales.

Deep learning: redes neuronales profundas

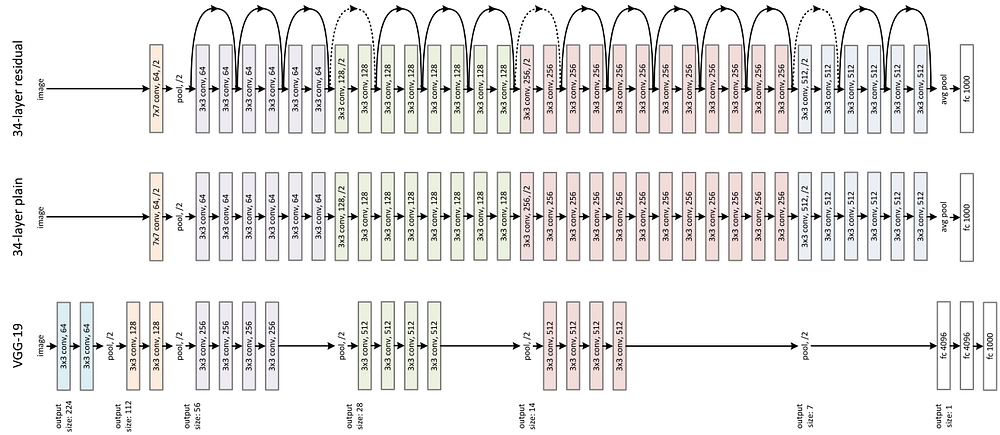

Deep learning es un subconjunto de modelos de Machine learning. En particular, en esta disciplina se estudian las redes neuronales profundas, que se caracterizan por tener una gran cantidad de capas ocultas en su estructura, lo que les permite implementar funciones de gran complejidad. Deep learning es un concepto relativamente nuevo, que se utiliza para referirse a las redes neuronales, y que se ha utilizado como una herramienta de marketing para atraer a nuevos investigadores y practicantes al área. Esto se debe a que en el pasado las redes neuronales han defraudado las expectativas que se tenían de ellas, debido a distintos tipos de dificultades técnicas en su desarrollo. Por lo tanto, se necesitaba limpiar su imagen, a través de este nuevo nombre que refleja mejor las nuevas tendencias en su desarrollo.

Algunas de las dificultades enfrentadas por las redes neuronales son, por ejemplo, que requieren de una gran cantidad de datos para funcionar bien, si no, tienden a sobreajustarse a los datos de entrenamiento (overfitting), lo que tiene como consecuencia una disminución de su desempeño. Además, se requiere de una gran capacidad de cómputo para trabajar con las redes neuronales profundas. Estas dos barreras técnicas se han ido superando en la actualidad, con el surgimiento del Big Data y la utilización de procesadores gráficos (GPU) para acelerar el procesamiento de las redes neuronales.

Machine Learning tradicional vs Deep Learning

Las redes neuronales se tratan como una disciplina separada del machine learning tradicional debido a sus particularidades. No obstante, hay que mencionar que no existe un modelo que sea el mejor para cualquier situación (https://en.wikipedia.org/wiki/No_free_lunch_theorem), sino que el modelo más adecuado depende del problema que se quiera resolver, del tipo de variables que se utilice, y de la cantidad y tipo de datos disponibles. También afectan factores como la velocidad en el ajuste o en la implementación del modelo, la capacidad de cómputo de la que se disponga, necesidades específicas del usuario (por ejemplo, interpretabilidad), y aspectos éticos.

Deep learning y Big data

El auge del deep learning se ha dado a la par con el surgimiento del big data, ya que el desempeño de las redes neuronales profundas aumenta en la medida que se cuente con más datos, debido a que se trata de modelos muy complejos, con millones de parámetros a estimar. Cuando se tienen pocos datos, es decir, muestras pequeñas, las redes neuronales no se desempeñan mejor que otros modelos, e incluso pueden tener un desempeño inferior. Sin embargo, a medida que aumenta la cantidad de datos disponibles, las redes neuronales se hacen imbatibles, incluso son capaces de superar en muchos casos el desempeño humano, que es la medida de referencia al entrenar modelos de Deep learning.

Como ejemplo, se menciona a GPT-3, una red neuronal profunda para NLP (Natural Language Processing), entrenada con toda la información de Wikipedia, todos los libros públicos de internet, y millones de artículos científicos y noticias. El modelo tiene 175.000 millones de parámetros, y tiene una gran cantidad de aplicaciones: es capaz de escribir código HTML, programar aplicaciones en distintos lenguajes, mantener conversaciones, escribir textos a partir de ideas, completar oraciones, redactar novelas imitando el estilo de algún escritor famoso, escribir textos con jerga legal, hacer traducciones, funcionar como un buscador al estilo de Google, etc. Es uno de los sistemas de inteligencia artificial más avanzado jamás creado.

Deep learning y datos no estructurados

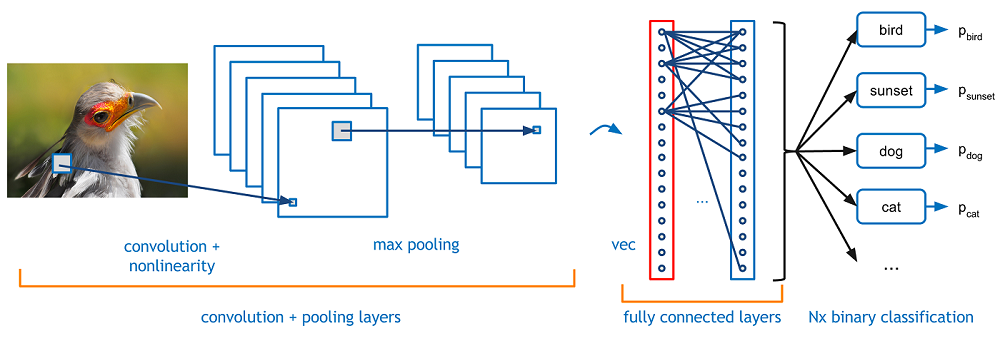

Deep learning también se ha hecho popular debido a que una gran cantidad de los datos creados y almacenados en la actualidad son datos no estructurados. Al respecto, las redes neuronales no tienen rival cuando se trata de procesar datos no estructurados, ya que son modelos altamente flexibles, que son capaces de funcionar con todo tipo de inputs y outputs. Principalmente, las redes neuronales destacan por su capacidad para trabajar con imágenes, sonido y texto.

Deep learning es el futuro

Para concluir el artículo, se destaca que en la actualidad muchos de los problemas que enfrentan las empresas se pueden resolver con métodos sencillos o usando machine learning tradicional. Sin embargo, los complejos problemas que enfrentarán las empresas en el futuro, junto con el desarrollo de la tecnología y el aumento en la cantidad de datos, hará que cada vez sea más deseable optar por solucionar problemas en base a redes neuronales profundas. De hecho, cuando los expertos en deep learning se refieren a los métodos utilizados para desarrollar redes neuronales y los contrastan con los métodos que se utilizan en el machine learning tradicional, se refieren a estos últimos como la antigua forma de hacer machine learning. Por el contrario, Deep learning se considera el estado del arte, la tecnología de vanguardia, la dirección en que se dirige la investigación y los esfuerzos de la profesión.